アクセスアップにかなり影響すると思われるメタデータの重複。

これがかなり多い方、アクセスダウンになるとこもあるので注意してください。

このメタデータの重複を解決するだけで、アクセスアップにもつながるはずです!

ウェブマスターツールのメタデータの重複はペナルティ対象に?

WordPressでサイトを作成していると、ウェブマスターツールで検索のデザインから、HTMLの改善を見ると、重複するメタデータ(descriptions)、タイトルタグの重複というのが出てきます。

これはURLが別ですが、該当するページのタイトルや、そのページの記事の内容が重複している事を意味しているようです。

これで、サイトに影響があるかどうかは分かりませんが、単純に考えてやはり、同一のタイトルや、記事がネット上に存在するという事は、そのサイトの評価は下がるだろうと踏んでいます。

HTMLの改善でのメタデータの重複は検索エンジンの評価に影響を及ぼす

やはり、以下、ウェブマスターツールでも言われているように、このメタデータの重複は検索エンジン的にも影響を及ぼすのかどうかは分かりませんが、評価としては低くなりそうです。

HTML の改善

以下の問題に対処すると、サイトのユーザー エクスペリエンスとパフォーマンスを向上できる可能性があります。

このように、HTMLの改善をする事により、ページのパフォーマンスが上がる事で検索エンジンからの評価も上がるのではという結論を自分で勝手に結論づけている訳です。

メタデータの重複を改善させよう

メタデータの重複をクリックすると、以下のように2つ以上のURLが現れます。

- /xxxx/1111

- /?p=76

注目する所が、”/?p=76”ってURLこれって自分のサイトでは見た事が無いURLですね。

なのにウェブマスターツールのHTMLの改善でで、意味不明のURLがあり、重複データとして現れます。

という事で、このよくわからないURLを削除しましょう。

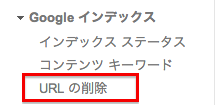

- ウェブマスターツールのGoogleインデックスから『URLの削除』をクリック

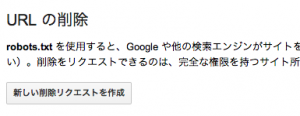

- URLの削除から、『新しい削除リクエストを作成』をクリック

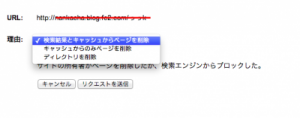

- どのような方法で削除をするか効かれるので該当の項目を洗濯しましょう。

この項目には3つの項目があります。

- 検索結果とキャッシュからページを削除

- キャッシュからのみページを削除

- ディレクトリを削除

それぞれを説明していくと、

- 検索結果とキャッシュからページを削除

Google検索結果から該当のURLの削除と、Googleで保存されている該当のURLを削除します。 - キャッシュからのみページを削除

Googleで保存されている該当のURLのみ削除します。(自分はあまりしようしません。) - ディレクトリを削除

Googleで確認しているサイトマップ上から該当のURLを削除します。

自分は、いつも『検索結果とキャッシュからページを削除』と『ディレクトリを削除』をセットでやっています。

URL削除だけではダメ!Robots.txtを使おう!

重複したURLを削除して、安心してもダメなんです。

このURLの削除は有効期限が3ヶ月?しかないとか確かあったような。。。記憶が間違っていれば失礼。

まぁ、今回削除してもそのうちまた重複データで出てきちゃいます。

URL の削除

robots.txt を使用すると、Google や他の検索エンジンがサイトをクロールする方法を指定したり、Google 検索結果からの URL の削除をリクエストしたりできます(削除要件をご確認ください)。削除をリクエストできるのは、完全な権限を持つサイト所有者とユーザーのみです。

こんな感じでコメントが削除URLを削除した後に出てきます。

ようは、robots.txtを書けって事なんだなと。

それではどうすればいいかって事なんですが、このrobotos.txtをテキストファイルで作成して、サイトトップディレクトリ直下に置くだけでOKなんです。

自分はレンタルサーバで”エックスサーバ”を使っているので以下のディレクトリにrobotos.txtを置きます。

※hogehoge.comの場合

/hogehoge.com/public_html/robots.txt

※サブドメイン使用時(sab.hogehoge.comなどの場合)

/hogehoge.net/public_html/sab/robots.txt

今回はGoogleロボットに削除したURLを見に行って欲しくないので、フィルターを書く事にします。

”/?p=76”っていうURLを見てほしくないので”/?”がついたディレクトリは全て見に行かないようにさせるため以下のようにテキストに記載します。

Disallow: /*?* Disallow: /*?

こうする事によってGoogleロボットは該当のURLを見に行かないので今後、メタデータの重複で”/?p=76”のようなURLは出てくる事はありません。

robots.txtの記載内容はの記事で紹介していますのでご参考に

まとめ

メタデータの重複は今後はかなり重要になると思います。

やはり、同じタイトルとページの記事がサイトに複数存在する事は、Googleロボットが巡回したときに混乱を招いてしまう可能性も考えられます。

大切な事はやはり、しっかりしたrobots.txtを作成すること。

それぞれのレンタルサーバでディレクトリなどが微妙に変わってくるので慎重に作成と設置を考えなければ行けないですね。

それでは!

エンジニアのオンライン学習

ITエンジニアにおすすめの教材、オンラインスクールです。

無料からエンジニアの学習ができる教材などまとめているので参考にしてください。

| おすすめオンライン教材 | |

| 自宅で学習ができるオンラインスクール | |

ITエンジニアの開発・検証・学習としてインターネット上で専用のサーバ(VPS)を利用しましょう!

実務経験はVPSで学べます。

コメントを残す